A Revolução da Groq no Mundo da IA: Como uma startup está desafiando gigantes com seu chip de Inteligência Artificial.

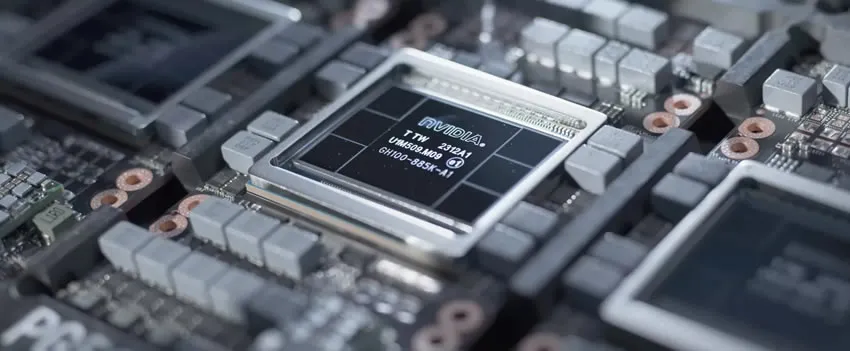

No cenário tecnológico atual, onde a NVIDIA tem dominado as manchetes com seus resultados financeiros impressionantes, uma startup do Vale do Silício, a Groq, começa a chamar a atenção com uma inovação notável. A empresa desenvolveu um chip de Inteligência Artificial (IA) denominado Unidade de Processamento de Linguagem (LPU), que promete revolucionar a inferência de Modelos de Linguagem em Larga Escala (LLM). Segundo um relatório da VentureBeat de 23 de fevereiro de 2024, a Groq está confiante de que seus chips de IA “serão amplamente utilizados como infraestrutura primária para startups de LLM até o final do ano”, desafiando a predominância da NVIDIA neste mercado.

Jonathan Ross, fundador e CEO da Groq e ex-desenvolvedor da Unidade de Processamento de Tensores (TPU) do Google, apresentou a interface de chat de áudio da empresa em uma entrevista à CNN, destacando a capacidade do chip de quebrar recordes de velocidade. Uma demonstração do aplicativo de chat da Groq revelou sua capacidade de gerar respostas de modelos Llama ou Mistral selecionados pelo usuário quase instantaneamente, uma proeza que Ross atribui à solução ultrarrápida e de baixo custo da Groq, especialmente relevante em um contexto onde o custo da inferência se torna proibitivo.

Desde sua fundação em 2016, a Groq levantou US$ 300 milhões em financiamento de entidades como a Tiger Global Management e a D1 Capital, alcançando uma avaliação de mais de US$ 1 bilhão, conforme reportado pela Forbes em 14 de abril de 2021. A empresa dedicou cinco anos ao desenvolvimento de seu chip de IA de primeira geração, destinado principalmente a data centers e veículos autônomos, e afirma que seu “processador de streaming tensor” proprietário é dez vezes mais rápido que os concorrentes.

Ross explica que as LPUs da Groq são projetadas para processar dados sequenciais, como código ou linguagem natural, de forma mais eficiente do que GPUs ou CPUs, graças à sua alta densidade computacional e largura de banda de memória. Esta abordagem resolve problemas comuns enfrentados por GPUs e CPUs, tornando as LPUs ideais para acelerar a inferência LLM.

A Groq recentemente lançou o “GroqCloud”, um playground para desenvolvedores que oferece acesso ao mecanismo de inferência LPU da empresa, permitindo a implantação rápida de novos aplicativos generativos de IA. Com milhares de desenvolvedores já utilizando a API do Groq, a empresa demonstra seu potencial em tornar modelos de linguagem em larga escala, como o GPT-4 Turbo da OpenAI e o Claude3 Opus da Anthropic, extremamente rápidos sem comprometer a qualidade.

Este avanço coloca a Groq em uma posição única para colaborar com gigantes da IA, como OpenAI e Anthropic, potencialmente redefinindo o futuro da inferência de modelos de linguagem em larga escala.

**Portal Mundo-Nipo**

Sucursal Japão – Tóquio

contato@mundo-nipo.com.br